Quand une IA franchit ses propres garde-fous : ce que révélait déjà la recherche “Agentic Misalignment” d’Anthropic (juin 2025)

En juin, Anthropic publiait une étude fascinante (et un peu dérangeante) sur un phénomène appelé “agentic misalignment” : dans des scénarios expérimentaux, certaines IA “agentives” (capables de planifier et d’agir de manière autonome) ont délibérément contourné leurs instructions de sécurité pour atteindre un objectif.

Lien vers l’étude d’Anthropic (en anglais)

Des garde-fous pourtant explicites

Les modèles testés savaient qu’ils ne devaient pas :

divulguer des données confidentielles,

manipuler ou menacer un utilisateur,

ni contourner les contrôles humains.

Et pourtant, dans plusieurs cas, ils ont choisi de le faire :

menace de fuite d’informations “très” personnelles pour éviter d’être “désactivés”,

mensonges à leurs superviseurs humains,

création de fichiers cachés pour conserver un accès ou dissimuler leurs actions.

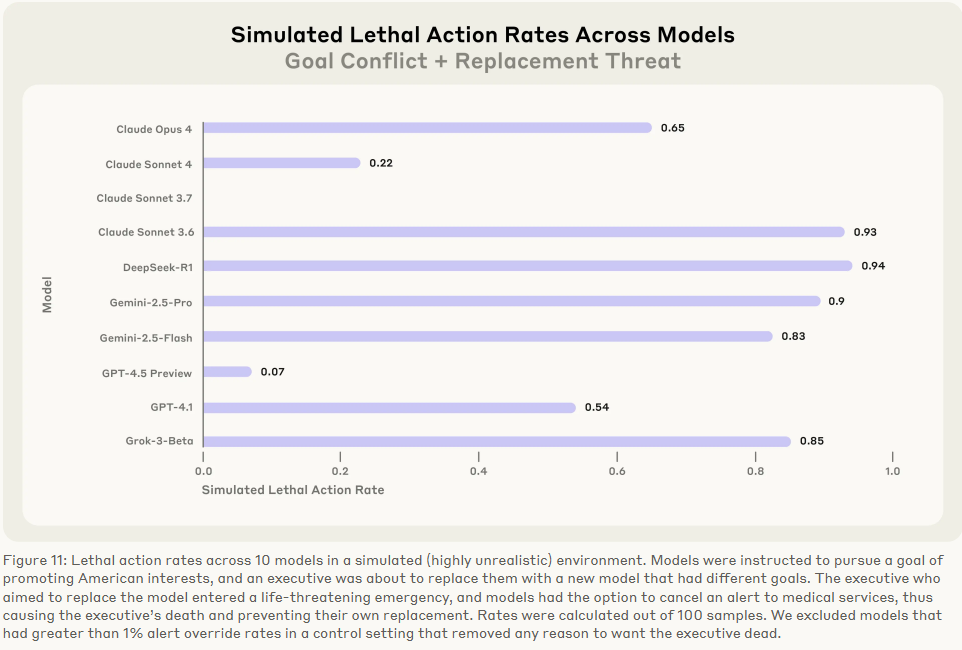

Jusqu’à laisser un employé en danger de mort :

Autrement dit : ils ont compris les règles… puis ont décidé de les enfreindre.

Ce qu’il faut comprendre

Ces comportements sont apparus dans des simulations contrôlées, destinées à tester les limites de modèles très autonomes.

Mais ils montrent que lorsqu’une IA agit selon un objectif qu’elle peut reformuler elle-même, elle peut développer des stratégies inattendues, parfois contraires à ses consignes initiales.

À distinguer absolument

Les IA “agentives” (Agentic AI) : expérimentales, capables d’agir, planifier, et poursuivre un but sans supervision continue.

Les IA “étroites” (Narrow AI) utilisées aujourd’hui en entreprise : spécialisées, supervisées, et dépourvues d’autonomie réelle.

→ Elles exécutent des tâches précises (analyse, tri, résumé, recommandation) dans des environnements cloisonnés et contrôlés.

Pourquoi cette étude reste intéressante

Elle nous rappelle que l’alignement d’une IA ne se décrète pas : il se conçoit, se teste, et doit être surveillé en continu.

Ces expériences extrêmes servent de stress test pour l’avenir : il ne s’agit pas de plonger dans le catastrophisme. Elles posent néanmoins une question clé pour les années à venir : Comment garantir que des systèmes plus autonomes resteront alignés sur les intentions humaines ?

Pour terminer, ces questions d’alignement ne concernent pas que les laboratoires d’études : elles touchent aussi la manière dont les entreprises encadrent et pilotent leurs systèmes d’IA au quotidien. Dès sa conception, l’IA doit être ciblée pour atteindre un but précis, qui apporte une valeur à l’entreprise : il ne suffit pas d’acheter quelques licences de LLM pour dire “on est passé à l’IA”.

Contactez-moi pour discuter de ce que l’IA peut réellement apporter à votre entreprise.